Ceci est une ancienne révision du document !

Table des matières

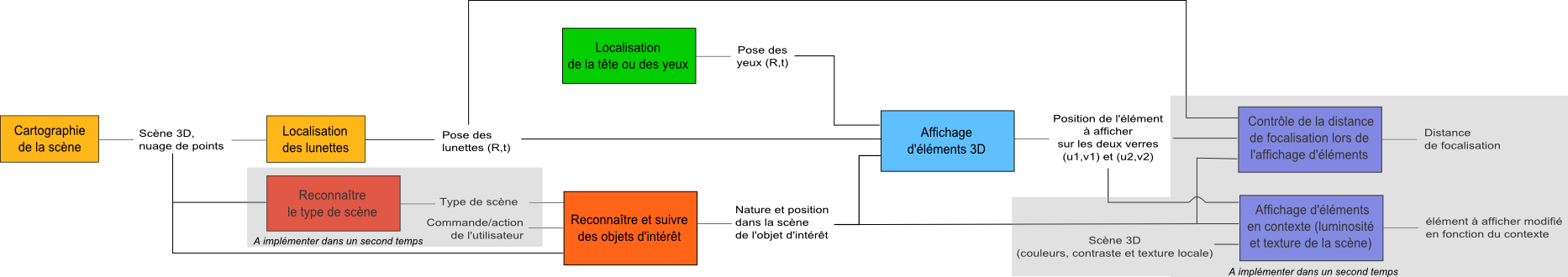

Ci dessous, la fonction principale d'une lunette de réalité augmentée, “faire apparaitre des éléments virtuels dans l'environnement réel visible par le porteur de lunette”, est décomposée par bloc puis en sous fonction et chaque fonction est analysée.

Décomposition par bloc

Cette fonction principale peut être décomposée en 4 blocs. Tout d'abord, il faut localiser les lunettes dans la scène cartographiée. C'est le premier bloc nommé ici “lien scène et lunette”. Pour ajouter des éléments virtuels en relation avec la scène, il est nécessaire de reconnaître des éléments présents dans l'environnement réel. Cette recherche d'éléments peut être facilitée si l'on connaît déjà le type de scène (cuisine, voiture, rue), ou la commande de l'utilisateur (“lui apporter une assistance pour monter un meuble” par exemple).

Puis il est nécessaire de connaître la position des yeux et leur direction pour déterminer sur quelle partie du verre il faut faire apparaitre l'élément virtuel. Ce bloc est nommé ici “Lien yeux et lunette”.

Le troisième bloc, “Affichage sur les lunettes”, concerne l'affichage 3D dans la scène des éléments virtuels. Cette affichage 3D, doit respecter la capacité de convergence de la vision humaine (lunette binoculaire), la faculté d’accommodation des cristallins (distance de focalisation variable) et la luminosité et le contraste de la scène.

Le dernier bloc concerne l'environnement sonore. Cette partie ne sera pas développée ici.

- Lien scène et lunette

- Estimation de la pose des lunettes dans la scène (localisation)

- Restitution 3D de la scène (cartographie)

- Reconnaître et suivre des objets d’intérêt

- Reconnaître les types de scène, l'associer à une situation, des activités. (Ceci permet de savoir quels types d'objet sont à trouver ou à reconnaitre dans la scène)

- Lien yeux et lunette

- Estimation de la position et l'orientation des yeux par rapport aux lunettes

- Affichage sur les lunettes

- Affichage 3D d'éléments sur les verres/filtres devant les yeux

- Affichage avec contrôle de la distance de focalisation

- Affichage d'éléments en contexte (luminosité et contraste de la scène)

- Environnement sonore

- Acquisition de l'environnement sonore 3D (localisation)

- Reconnaissance des types de son

- Reconnaissance de voix et du contenu du dialogue

- Restitution 3D d'un son

Entrée et sortie des blocs

On répertorie ensuite pour chaque fonction les informations nécessaires en entrée et les données en sorties.

- Lien scène et lunette

- Fonction localisation des lunettes

- Entrée : scène 3D (nuage de points)

- Sortie : pose des lunettes (R,t)

- Fonction Cartographie de la scène

- Entrée : /

- Sortie : scène 3D (nuage de points)

- Fonction reconnaître et suivre des objets d'intérêt

- Entrée : type de scène, scène 3D (nuage de points), commande/action de l'utilisateur

- Sortie : nature de l'objet d'intérêt et leur position dans la scène

- Fonction reconnaitre le type de scène

- Entrée : scène 3D (nuage de points)

- Sortie : type de scène

- Lien yeux et lunette

- Fonction localisation des yeux

- Entrée : /

- Sortie : pose des yeux (R,t)

- Affichage sur les lunettes

- Fonction affichage d'éléments 3D

- Entrée : pose des yeux (R,t), pose des lunettes (R,t), position dans la scène de l'élément à afficher

- Sortie : position de l'élément à afficher sur les deux verres (u1,v1) et (u2,v2)

- Fonction contrôle de la distance de focalisation lors de l'affichage d'éléments

- Entrée : pose des lunettes (R,t), position dans la scène de l'élément à afficher, position de l'élément à afficher sur les deux verres (u1,v1) et (u2,v2)

- Sortie : distance de focalisation ajustée en fonction de la distance entre l'élément et la lunette

- Fonction affichage d'éléments en contexte (luminosité et contraste de la scène)

- Entrée : scène 3D (nuage de points, position et intensité des sources lumineuses, couleurs et contraste), position dans la scène de l'élément à afficher, position de l'élément à afficher sur les deux verres (u1,v1) et (u2,v2)

- Sortie : Affichage d'éléments en contexte (prise en compte de l'intensité, la direction et la couleur de l'éclairage de la scène).

- Environnement sonore

- Non traité pour le moment

Cas limites, risques et tests à effectuer

Pour chaque bloc, on recense les limites et les contraintes des sous fonctions. Des tests seront à réaliser pour chacune de ces remarques.

- Lien scène et lunette

- A partir de quelle erreur d'estimation de la pose de la lunette, le porteur de lunette remarque une différence ?

- Lien yeux et lunette

- A partir de quelle erreur d'estimation de la pose des yeux par rapport à la lunette, le porteur de lunette remarque une différence ?

- Affichage sur les lunettes

- Répondre à la résolution limite de l’œil (~1 arcmin)

- Quel peut être l'erreur limite acceptable sur la distance de focalisation de l'élément affiché ?

- Quels sont les différents cas possibles où il est nécessaire de retravailler l'aspect de l'élément à afficher (fort contraste, ombres, lumière colorée qui filtre les couleurs de la scène) ?

- Quel peut être la tolérance du porteur de lunette à voir des objets apparaître et disparaître ?

- Quel est l'effet ressenti par le porteur de lunette, lorsque des éléments restent constamment dans le champs de vision ?

- Est-ce que la position et l'orientation des yeux a une importance sur l'affichage des éléments sur le verre ou est-ce que la position seulement importe ?

- Environnement sonore

- Non traité pour le moment

Implémentation possible

Pour chacune des sous fonctions, on indique les matériels et les algorithmes possibles. Puis on répertorie les implémentations de chaque fonction par ordre de complexité (en prenant en compte que certaines des solutions sont déjà disponibles au sein du laboratoire).

- Lien scène et lunette

- Fonction localisation des lunettes

- Outils hardware :

- vicon

- système monoculaire

- système binoculaire

- système RGBD

- IMU (accéléromètre, gyromètre, magnétomètre)

- Outils software/algorithmique :

- SLAM visuel, filtre de Kalman

- Ordre d'implémentation :

- position de la tête fixe et connue

- vicon (déjà sur étagère, grande précision sur l'estimation de pose)

- Système RGBD (ou système binoculaire) + IMU

- Fonction cartographie de la scène

- Outils Hardware :

- idem

- Outils Software/algorithmique :

- idem

- Ordre d'implémentation :

- position d'élément de la scène fixe et connue

- système RGBD (ou système binoculaire) + IMU

- Fonction reconnaître et suivre des objets d'intérêt

- Outils hardware : idem

- Outils software/algorithmique : filtre de Kalman pour l'estimation de la pose des objets

- Ordre d'implémentation :

- idem

- Fonction reconnaitre le type de scène

- Non traité pour le moment

- Lien yeux et lunette

- Fonction localisation des yeux

- Outils hardware : eye tracker

- Outils software/algorithmique : pas à notre charge

- Ordre d'implémentation :

- pose des yeux fixe et connue

- eye tracker (Il faut être capable de récupérer R et t de la pose des yeux relativement à la lunette)

- Affichage sur les lunettes

- Fonction affichage d'éléments 3D

- Outils hardware :

- filtre : afficheur LCD démonté

- lunette avec verre transparent et projection d'hologramme

- lunette immersive où on restitue en fond de scène l'environnement réel

- Outils software/algorithmique : géométrie projective, modèle de caméra trou d'épingle, homographie entre différent repère de travail (scène, lunette/filtre, œil)

- Fonction contrôle de la distance de focalisation lors de l'affichage d'éléments

- Non traité pour le moment

- Fonction affichage d'éléments en contexte (luminosité et contraste de la scène)

- Non traité pour le moment

- Environnement sonore

- Non traité pour le moment

Lien scène et lunette : exemple de matériel

camera stereo ueye

ToF (time of light) camera

Kinect (issue de Microsoft, hardware design par PrimeSenze racheté par Apple)

Creative senz3d (portée de 15 à 99 cm) : http://fr.creative.com/p/web-cameras/creative-senz3d

Depth Senze 325 (par Sorftkinetic, protée de 15 à 100 cm) : http://www.softkinetic.com/Store/tabid/579/ProductID/6/language/fr-BE/Default.aspx

Camboard (par pmdtechnologies, portée 20 à 100 cm) : http://pmdtec.com/products_services/reference_design_pico_pico_s.php

lens array camera

Pelican camera par Pelican imaging (rachetée par Nokia, 16 lens array camera) : http://www.pelicanimaging.com/technology/camera.html

Lien yeux et lunette : exemple de matériel

eye tracker

Affichage sur les lunettes : exemple de matériel

écran LCD avec électronique déportable

nécessite une nappe pour deporter l'electronique: http://nicelcd.en.ec21.com/HAMI_8_TFT_LCD_TV--1111736_1112457.html

exemple de vp avec le hami 8: http://www.allinbox.com/vinzz/vinzz.htm

différents vp avec tft: http://www.allinbox.com/retrotft.php et http://www.allinbox.com/DIY_AUDVID/DIY_AUDVID.php

écran 7“ pour raspberry pi et convertisser HDMI/VGA: http://www.sainsmart.com/7-inch-tft-lcd-monitor-for-raspberry-pi-touch-screen-driver-board-hdmi-vga-2av-1.html

écran 128*64 pixel N/B: http://fr.farnell.com/jsp/search/browse.jsp?N=2014+202998&Ntk=gensearch&Ntt=lcd+graphique+128&Ntx=mode+matchallpartial

http://fr.farnell.com/midas/mc128064c6w-fptlw/lcd-128x64-fstn-blanc-b-l/dp/2063191